Privacidad vs. confidencialidad, ¿en qué se diferencian y de qué nos protegen?

Una de las posibles definiciones de privacidad es el derecho que tenemos todas las personas a controlar la información acerca de uno mismo, y sobre todo quién puede tener acceso a ella y bajo qué condiciones. En muchos casos la privacidad es un concepto que se entremezcla con la seguridad; sin embargo, la seguridad es un concepto mucho más amplio que engloba diferentes mecanismos.

La seguridad nos proporciona herramientas que nos ayudan a proteger la privacidad. Una de las técnicas de seguridad más utilizadas para proteger la información es el cifrado de los datos. El cifrado nos permite proteger nuestra información frente a un intento de acceso no autorizado. Entonces, si al cifrar estoy protegiendo mis datos y el acceso a ellos, ¿no es suficiente?

Una de las razones para que la respuesta a esta pregunta sea “no” es que, en muchos casos, la información de los metadatos queda desprotegida. Por ejemplo, podemos cifrar el contenido de un correo electrónico y proteger el mensaje, pero para enviarlo necesitamos incluir la dirección de destino. Si el correo electrónico enviado va dirigido, por ejemplo, a un partido político, estaría revelando información sensible a pesar de haber protegido el contenido del mensaje.

Por otra parte, existen determinados escenarios en los que no podemos cifrar la información. Por ejemplo, si queremos externalizar el procesamiento de una base de datos o liberarla para que terceros realicen análisis o estudios con fines estadísticos. En este tipo de escenarios muchas veces nos encontramos con el problema de que la base de datos contiene una gran cantidad de información personal o sensible, e incluso aunque eliminemos los identificadores personales (por ejemplo el nombre o el número de pasaporte), puede no ser suficiente para proteger la privacidad de los individuos.

Anonimización, protegiendo nuestra privacidad

La anonimización es un conjunto de técnicas que permiten proteger la privacidad mediante la modificación de los datos (incluso su eliminación). Lo que se busca con esta técnica es alterar los datos de tal modo que, aunque sean procesados posteriormente por terceros, no se pueda revelar la identidad ni ciertos atributos sensibles de las personas cuyos datos están siendo procesados.

La gestión de la privacidad se encuentra regulada a nivel europeo. La GDPR (General Data Protection Regulation) es la nueva normativa europea que busca regular el tratamiento de nuestros datos personales [1]. Esta regulación establece que los datos deben quedar sujetos a las garantías adecuadas, minimizando los datos personales. Entre las medidas que se mencionan en la normativa aparece la pseudonimización. La pseudonimización consiste en sustituir un identificador que es único (como un número de pasaporte) por otro valor diferente, también único. Aunque este mecanismo ofrece ciertas garantías de privacidad, se ha demostrado que su nivel de protección resulta insuficiente en muchos escenarios, ya que se puede llegar a identificar a una persona cuyos datos han sido pseudonimizados [2].

La anonimización sin embargo ofrece garantías de protección mucho mayores que la pseudonimización, ya que su objetivo último es que los datos anonimizados no puedan ser asociados de nuevo a la identidad de las personas a las que pertenecen. Además, la GDPR nos indica que, siempre que sea posible aplicar medidas para reducir el riesgo de identificación, se utilizarán las tecnologías necesarias para ello. La anonimización es una de estas tecnologías.

Principales técnicas de anonimización de datos

Para anonimizar los datos correctamente el primer paso es analizar cómo es la estructura de la base de datos a la que queremos dar acceso a terceros y clasificar los datos en tres categorías:

- Datos sensibles: son los datos que tienen un cierto valor, sobre los que vamos a querer extraer conclusiones en un análisis posterior (condición médica, salarios, etc.).

- Identificadores: son aquellos campos de la base de datos que permiten identificar a una persona de forma única, como puede ser el DNI, teléfono móvil…

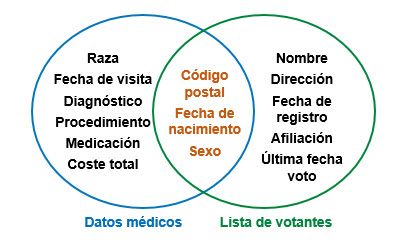

- Quasi-identificadores: son todos los demás datos, es decir, aquellos datos personales que no son identificadores, y que no tienen un valor especial para nuestro análisis. Los quasi-identificadores por sí solos no revelan información, pero cuando se combinan entre ellos o con otras fuentes externas de datos pueden llegar a desvelar nuestra identidad.

Los quasi-identificadores son datos especialmente relevantes para nuestro análisis, ya que éstos son los datos que vamos a alterar para proteger la privacidad de las personas. Es importante destacar también que los quasi-identificadores no serán los mismos en todos los casos de uso, ya que dependerán del análisis que queramos hacer posteriormente con los datos.

Una vez los datos se han clasificado, se aplicarán diferentes técnicas de anonimización sobre los mismos:

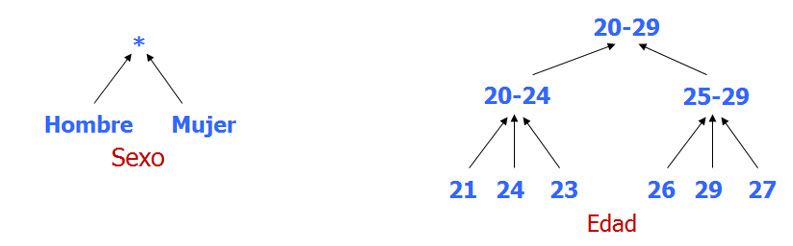

- Generalización: consiste en agregar los datos que tienen un significado semántico similar en otras clases con un valor menos específico.

- Aleatorización: técnica que consiste en aplicar una modificación aleatoria a los datos. Se usan principalmente dos mecanismos:

- Inyección de ruido: introduce perturbaciones en los datos haciendo que sean menos precisos.

- Permutaciones: aleatoriza las asociaciones entre atributos, sin cambiar los valores.

- Eliminación: consiste en eliminar completamente un atributo o un registro.

Existen diferentes aproximaciones para la anonimización basadas en la generalización de atributos. k-anonymity [3] busca que cada persona de la base de datos sea indistinguible de al menos otros k-1 individuos que también están en la base de datos. Partiendo de k-anonimity surgen otras aproximaciones más restrictivas. Un ejemplo es l-diversity [4], que fuerza la existencia de al menos l valores diferentes de datos sensibles en cada clase de equivalencia establecida por k-anonymity. Otro ejemplo es t-closeness [5], que busca generalizar los datos de forma que la distribución de quasi-identificadores en cada clase de equivalencia sea similar a la distribución de datos original.

En algunos casos no se desea anonimizar ni publicar un conjunto de datos completo, sino que se protege la privacidad mediante la anonimización de los resultados de las consultas al mismo. De este modo, la técnica conocida como differential privacy [6] consiste en introducir ruido en las respuestas, protegiendo la privacidad de los sujetos presentes en los datos.

¿De qué riesgos nos protege la anonimización?

Como hemos visto, a pesar de haber eliminado los identificadores de una base de datos, en muchos casos la combinación de varios atributos nos permitiría identificar igualmente a la persona a la que pertenecen los datos. Por ejemplo, el 87% de la población de los Estados Unidos es identificable utilizando únicamente su código postal, su fecha de nacimiento y su sexo [3]; sin embargo, la identificación no es el único riesgo del que nos protege la anonimización:

- Singling out: el objetivo es ser capaz de re-identificar a una persona en la base de datos anonimizada

- Linkability: se relaciona que dos registros de datos pertenecen a la misma persona, aunque no se sepa a quién exactamente

- Inference: se deduce un valor sensible a partir de otro conjunto de datos

Retos de la anonimización

Es importante resaltar que no hay una forma de anonimizar única, y las técnicas a utilizar variarán según cómo son nuestros datos, qué queremos hacer con ellos y qué requisitos de privacidad tenemos.

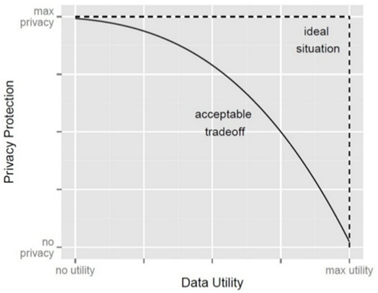

Al anonimizar los datos, se pierde parte de la información que contienen y, por tanto, disminuye su utilidad. El principal reto de la anonimización es por tanto mantener un balance adecuado entre el nivel de privacidad y utilidad de los datos.

Hasta ahora hemos visto que si tenemos una base de datos personales, no debemos darle acceso a terceros para que realicen estudios sobre ellos sin haber aplicado antes ninguna medida para proteger la información. También hemos visto que utilizar pseudónimos no es suficiente, y que la anonimización ofrece en general mejores garantías de privacidad. Pero si anonimizamos nuestros datos entonces, ¿qué puede ir mal?

La anonimización no es una técnica sencilla ni directa de aplicar y realizar una buena anonimización depende de un gran número de factores.

Un ejemplo de ello es el caso de un grupo de seguros de Massachusetts que en los años 90 decidió publicar las visitas de los empleados estatales a los hospitales, previamente anonimizados. La base de datos contenía unos 135.000 registros aproximadamente. El gobernador de Massachusetts aseguró que dado que se habían eliminado los nombres, direcciones y números de la seguridad social, la identidad de los pacientes estaba completamente protegida. Sin embargo un estudiante demostró que era capaz de identificar los registros hospitalarios del gobernador, utilizando únicamente su fecha de nacimiento, sexo y código postal. Cruzando la base de datos con la lista de votantes (pública en Estados Unidos), detectó que en la ciudad en la que vivía el gobernador, sólo 6 personas tenían la misma fecha de nacimiento que él; 3 de ellos eran hombres; y sólo 1 vivía en el mismo código postal [3]. De esta forma demostró que los datos que pueden parecer anónimos a simple vista, no tienen por qué serlo necesariamente.

Otro caso es el del Personal Genome Project en 2013. Los datos de los participantes eran teóricamente anónimos, ya que se eliminaban sus nombres y direcciones de los perfiles, pero se dejó información como su información médica, información genómica, fecha de nacimiento, sexo y código postal. Utilizando estos datos y la misma lista de votantes del escenario anterior un grupo de expertos en privacidad fue capaz de desvelar la identidad de entre el 84 y 97% de los perfiles publicados [7].

¿Qué hace Gradiant en este ámbito?

Gradiant trabaja en el diseño y desarrollo de nuevos mecanismos de anonimización, que ofrezcan simultáneamente las mejores garantías de privacidad y utilidad para los datos. Nuestras soluciones permiten:

- Medir el nivel de privacidad de datos anonimizados y no anonimizados.

- Mejorar los procesos de anonimización existentes.

- Medir la pérdida de utilidad de los datos anonimizados.

- Automatizar los procesos de anonimización de datos.

Estos desarrollos y tecnologías son aplicables en diferentes campos. Mediante su utilización con datos bancarios, por ejemplo, han permitido externalizar los cálculos de modelos de detección de fraude de tarjeta de crédito o de evaluación de riesgo en préstamos, garantizando al mismo tiempo la protección de la privacidad de los datos de los usuarios.

Proyecto WITDOM

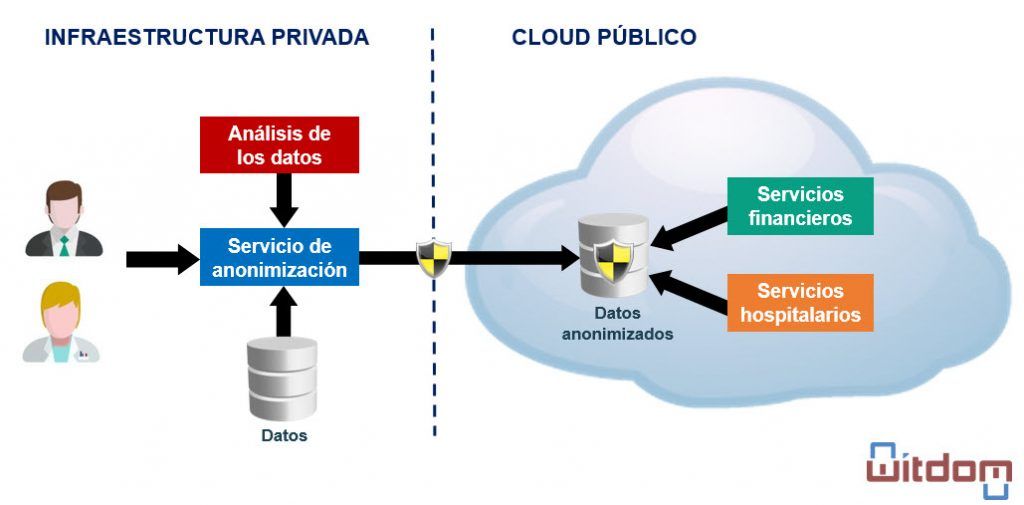

WITDOM es un proyecto H2020 cuyo objetivo es la generación de un framework que permita proteger datos sensibles cuando se externalizan a entornos no confiables. Contempla dos escenarios de aplicación: un hospital y un banco. En ambos escenarios existen procesos que actualmente se ejecutan en sus infraestructuras privadas y que presentan una elevada demanda computacional o de almacenamiento. Dado que gestionan datos sensibles, estos procesos no se pueden externalizar directamente. Para solucionarlo en WITDOM se desarrolla un conjunto de herramientas criptográficas y no criptográficas que permiten preservar la privacidad al externalizar estos procesos. Entre estas herramientas se encuentra la anonimización, desarrollada por Gradiant.

Autores: Lilian Adkinson y Pablo Dago, investigadores senior expertos en seguridad del área de Servicios y Aplicaciones en Gradiant

Referencias

[1] http://ec.europa.eu/justice/data-protection/reform/files/regulation_oj_en.pdf

[2] Opinion 05/2014 on Anonymisation Techniques. Article 29, Data Protection Working Party

[3] Sweeney, L. (2002). k-anonymity: A model for protecting privacy. International Journal of Uncertainty, Fuzziness and Knowledge-Based Systems, 10(05), 557-570.

[4] Machanavajjhala, A., Kifer, D., Gehrke, J., & Venkitasubramaniam, M. (2007). l-diversity: Privacy beyond k-anonymity. ACM Transactions on Knowledge Discovery from Data (TKDD), 1(1), 3.

[5] Li, N., Li, T., & Venkatasubramanian, S. (2007, April). t-closeness: Privacy beyond k-anonymity and l-diversity. In Data Engineering, 2007. ICDE 2007. IEEE 23rd International Conference on (pp. 106-115). IEEE.

[6] Dwork, C. (2008, April). Differential privacy: A survey of results. In International Conference on Theory and Applications of Models of Computation (pp. 1-19). Springer Berlin Heidelberg.

[7] Sweeney, L., Abu, A., & Winn, J. (2013). Identifying participants in the personal genome project by name.