El auge del fraude digital con inteligencia artificial

Imagen generada con Chat GPT-1

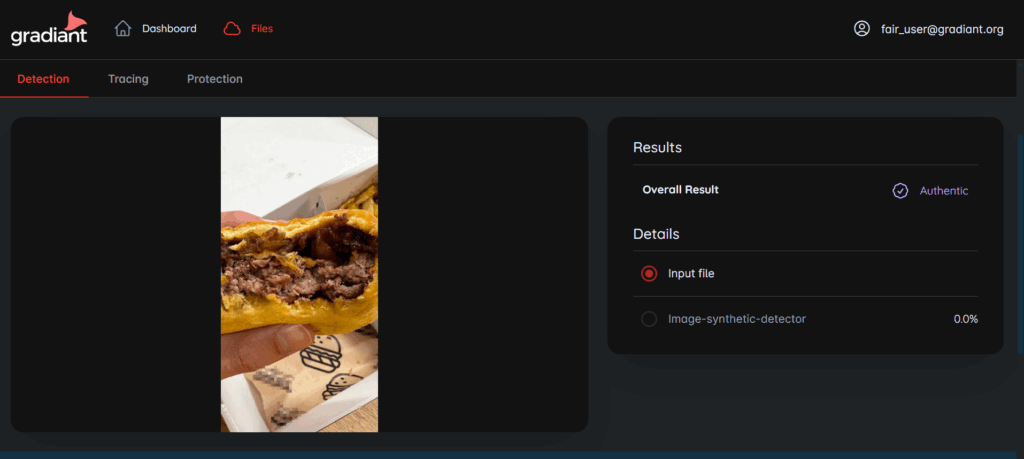

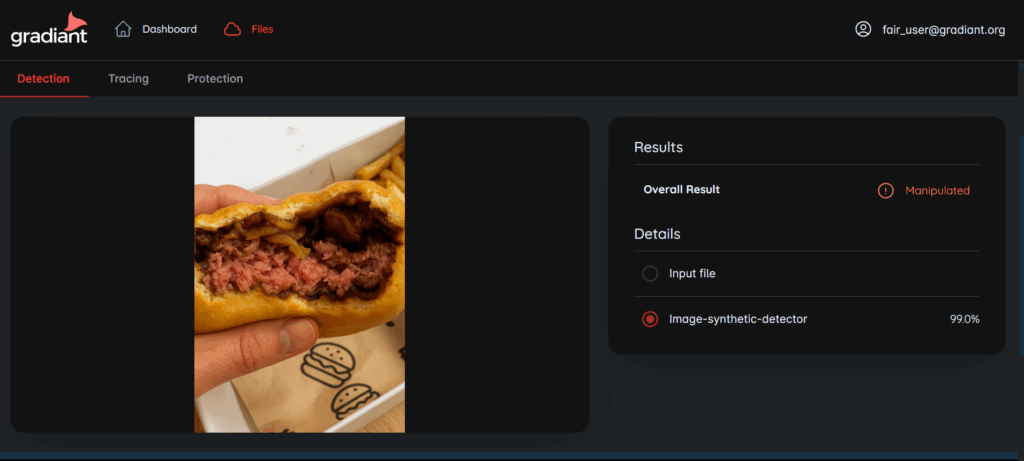

Desde reclamar un reembolso en una app de comida con una foto falsa hasta suplantar la voz de un CEO para robar millones: la inteligencia artificial está dando forma a nuevas formas de estafa tan sutiles como peligrosas. Imagina abrir la puerta para recibir tu pedido de comida a domicilio. Todo parece normal y disfrutarás de tu cena. La hamburguesa que pediste luce apetitosa. Si tienes tiempo, darás hasta una buena reseña. Sin embargo, hay personas que han dado con una nueva forma de estafa que se está extendiendo rápidamente y todo gracias a la inteligencia artificial. Estos estafadores logran cenar gratis gracias a la manipulación digital de una foto del plato para que parezca en mal estado. Con herramientas de IA generativa como Chat GPT, basta un simple texto como “simular carne poco hecha”. De esta forma, transforman la imagen en segundos, haciendo que la hamburguesa parezca cruda. Esta foto alterada se adjunta a una reclamación en la aplicación, y en cuestión de minutos, llega el reembolso.

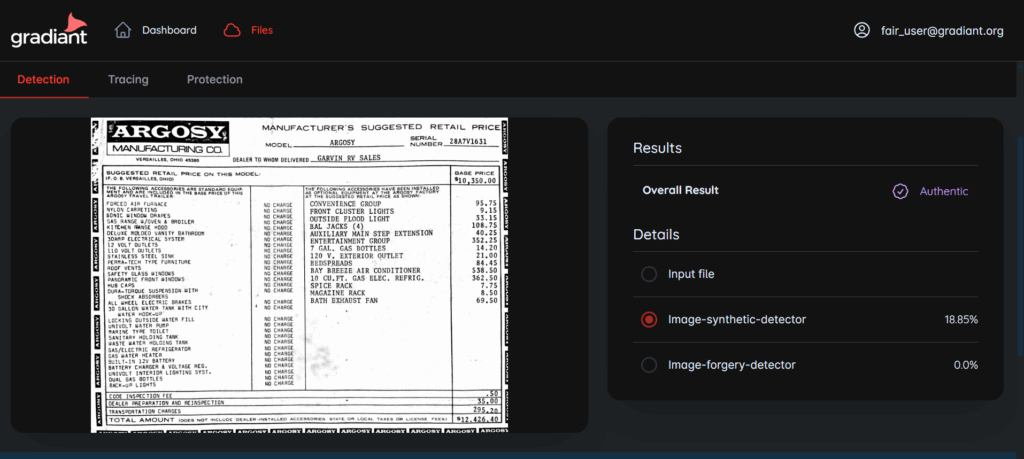

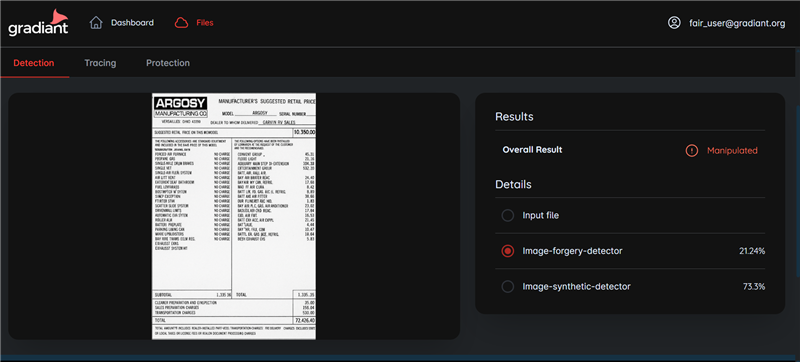

Este fraude “low-cost”, conocido como shallowfake o ‘engaño superficial’, se basa en pequeñas manipulaciones digitales que resultan tan realistas que logran sortear los sistemas de control de las empresas. Y no se limita a las apps de comida; aseguradoras, tiendas online y hasta la administración pública ven un aumento en reclamaciones falsas basadas en imágenes o documentos modificados con IA, como facturas o contratos. Empresas como Uber Eats han visto un aumento en las estafas desde 2024, mientras que aseguradoras en Reino Unido han reportado un incremento del 300% en el uso de IA para retocar documentos y fotos desde 2021. En España, AXA detecta manipulaciones digitales en el 30% de los documentos de siniestros que recibe, frente al 3% de hace unos años. Piénsalo: pedirle a una IA que añada un rasguño a un coche o modifique una factura es sorprendentemente fácil y el resultado, a menudo, indistinguible.

Los ‘shallowfakes’ son solo la punta del iceberg

El fraude con IA ha escalado a niveles mucho más sofisticados. ¿Recuerdas el ejemplo del inicio sobre una llamada de tu banco o tu propio jefe solicitando una transferencia urgente? Esa voz convincente no era real, sino una clonación hecha con inteligencia artificial, una estafa conocida como voice hacking. El voice hacking es una técnica que replica la voz de una persona para decir un mensaje diferente al real. El voice hacking utiliza tecnologías como la clonación de voz (Voice Cloning), que emplea IA y Deep Learning para analizar grabaciones previas y crear un modelo que replica el patrón de habla, tono, ritmo y acento de la víctima.

Casos de la vida real son escalofriantes. Mujeres como Jennifer DeStefano y Ruth Card recibieron llamadas que parecían provenir de sus familiares (hija y nieto, respectivamente) supuestamente secuestrados, requiriendo ayuda. En el ámbito empresarial, la “estafa del CEO” se ha vuelto tristemente común: un empleado recibe una llamada de alguien que suena exactamente como su superior ordenando una transferencia a una cuenta específica. Un caso notorio involucró a una compañía de Hong Kong, donde los estafadores lograron 23 millones de euros. No fue solo una llamada; tuvieron lugar varias videollamadas a lo largo de una semana con falsos directivos recreados con deepfake de voz y vídeo. Otros fraudes han utilizado deepfakes de voz para contratar servicios a nombre de terceros o para crear contenido falso, como un anuncio donde la voz de Taylor Swift promocionaba un juego de ollas y sartenes. La creatividad de los ciberdelincuentes parece no tener límites.

Una amenaza con coste real

Esta creciente amenaza tiene un coste real y significativo para las empresas a nivel global. Un estudio reciente de Regula, The Deepfake Trends 2024, reveló que el fraude con deepfakes cuesta en promedio $450,000 a la mayoría de las organizaciones encuestadas. Sin embargo, el sector de servicios financieros sufre una carga aún mayor, superando los $603,000 en pérdidas promedio por empresa. La situación es grave: el 92% de las empresas encuestadas reportaron pérdidas de hasta $450,000, y un preocupante 10% tuvo pérdidas superiores al millón de dólares.

Lo más alarmante es que la carga financiera promedio del fraude de identidad casi se duplicó en solo dos años, pasando de unos $230,000 en 2022 a las cifras actuales. El sector financiero, especialmente Fintech ($637,000 en pérdidas promedio) y la banca tradicional ($570,000), son los más afectados por los deepfakes de video y audio. Geográficamente, México reportó las pérdidas promedio más altas ($627,000), seguido por Singapur ($577,000) y EE. UU. ($438,000).

A pesar de estas cifras, existe una brecha preocupante: el 56% de las empresas confían mucho en su capacidad para detectar deepfakes, pero solo el 6% ha logrado evitar pérdidas financieras por estos ataques. Esto sugiere que muchas organizaciones no están preparadas para la sofisticación de estas amenazas.

fAIr: IA para detectar imágenes, vídeos y audios sintéticos

Pero no todo está perdido. A medida que la creatividad de los ciberdelincuentes evoluciona, también lo hacen las tecnologías para combatir estos delitos. Como hemos visto, el ojo y el oído humano no son fiables para detectar deepfakes y deepvoices; se necesita tecnología avanzada. En este contexto, en Gradiant aplicamos tecnologías avanzadas de inteligencia artificial y análisis forense multimedia para abordar el desafío de los deepfakes. Con un profundo bagaje y experiencia en áreas como análisis multimedia, Inteligencia Artificial aplicada, seguridad y privacidad, sistemas de comunicaciones y tecnologías del lenguaje, estamos desarrollando soluciones robustas.

De esta experiencia nace fAIr by Gradiant, una plataforma que utiliza inteligencia artificial multimodal para combatir las amenazas derivadas del uso malicioso de la IA generativa, detectando si vídeos, imágenes o audios han sido manipulados o generados artificialmente y ofreciéndonos plena trazabilidad de su difusión en redes y mensajería. Incluso, gracias a esta tecnología, es posible proteger archivos multimedia para blindarnos y evitar su posible manipulación con fines fraudulentos o maliciosos.

Análisis Multimodal

La fortaleza de fAIr reside en su enfoque de análisis multimodal, que fusiona las predicciones de sistemas de detección sobre audio, imagen y vídeo para una doble comprobación de la veracidad. Sus modelos de IA, entrenados con técnicas novedosas de selección, curado y aumentado de datos, poseen grandes capacidades de generalización y pueden fijarse en detalles que escapan a la percepción humana. Esta solución podría haber prevenido fraudes como el de la videollamada en Hong Kong.

En definitiva, si bien la IA ha abierto la puerta a nuevas formas de fraude digital, la misma tecnología, aplicada de manera inteligente y multimodal como lo hace fAIr, es una herramienta esencial para verificar la autenticidad del contenido digital, proteger recursos y reforzar la confianza en un entorno digital cada vez más complejo y amenazado.

Esta publicación es parte de fAIr (Fight Fire with fAIr), financiado por la Unión Europea NextGeneration-EU y PRTR a través de INCIBE.

Los puntos de vista y las opiniones expresadas son únicamente los del autor o autores y no reflejan necesariamente los de la Unión Europea o la Comisión Europea. Ni la Unión Europea ni la Comisión Europea son responsables de ellas.